KI-Modelle verfälschen menschliche Gefühle

LLMs wie ChatGPT nehmen Emotionen laut Studie der Warwick Business School inkorrekt wahr

|

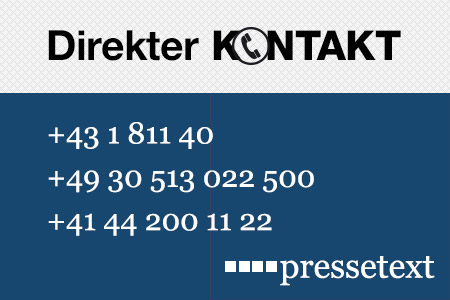

KI in Aktion: Gefühle werden oftmals nivelliert (Foto: pixabay.com, Chris_and_Ralph) |

Coventry (pte014/26.02.2025/12:30)

Fasst ein sogenanntes "Large Language Model" (LLM) wie ChatGPT zusammen, was Menschen zu einem Thema zu sagen haben, kann es hinsichtlich der beteiligten Gefühle zu einem falschen Eindruck kommen. Das ist auch dann der Fall, wenn LLMs die Fakten effizient zusammenfassen. Zu diesem Ergebnis kommt eine Studie der Warwick Business School.

LLMs verzerren Daten

Die Studienautoren betonen, dass LLMs in der Forschung zwar eine immer größere Rolle spielen. Diese großen Sprachmodelle sind dabei jedoch kein durchsichtiges Fenster zur Welt, sondern können den Content in einem anderen Ton und mit einem anderen Schwerpunkt als die originalen Daten präsentieren und zusammenfassen. In der Folge kann es zur Verzerrung der Forschungsergebnisse kommen, warnen die Warwick-Experten.

Die Forscher haben einen Datensatz, bestehend aus 18.896.054 Tweets, die den Begriff "Klimawandel" enthielten, mit Tweets verglichen, die von LLMs umformuliert wurden. Die originalen Daten stammten aus dem Zeitraum Januar 2019 bis Dezember 2021. Dabei zeigte sich, dass die von den LLMs erstellten Tweets neutraler waren als die Originale.

Stimmungslage anpassen

Diese emotionale Abstumpfung trat laut den Fachleuten unabhängig von den eingesetzten Prompts oder der Komplexität der LLMs auf. Ein ähnlicher Effekt ergab sich, als die Tools ersucht wurden, Kundenrezensionen auf Amazon umzuformulieren. Laut der leitenden Wissenschaftlerin Yi Ding könnten Vorhersagemodelle eingesetzt werde, um die Stimmungslagen rückwirkend wieder anzupassen. Details sind in "PNAS Nexus" veröffentlicht worden.

(Ende)| Aussender: | pressetext.redaktion |

| Ansprechpartner: | Moritz Bergmann |

| Tel.: | +43-1-81140-300 |

| E-Mail: | bergmann@pressetext.com |

| Website: | www.pressetext.com |